Nous recevons fréquemment des demandes relatives aux appareils censés mesurer les ondes et les champs électromagnétiques et, par delà, les pollutions engendrées par ces phénomènes physiques. A ce propos, il nous paraît utile de redéfinir certains concepts de base.

La mesure des phénomènes physiques relève de la métrologie, cette « science des poids et mesures » qui s’applique à toutes les techniques de mesure, quelles qu’elles soient, et qui est conditionnée par des règles bien précises. Car on ne mesure pas n’importe quoi n’importe comment et avec n’importe quel matériel.

La métrologie des rayonnements et des champs d’énergie est d’autant plus complexe qu’elle concerne des phénomènes qui échappent totalement à nos sens naturels. Nous ne pouvons ni les voir, ni les entendre (1), ni les sentir. Si nous pouvons « estimer » une dimension sans recourir à un appareil de mesure, il nous est impossible d’estimer la densité de puissance d’un rayonnement (à l’exception des rayonnements visibles, bien entendu). En outre, les phénomènes liés à la propa-gation des ondes électromagnétiques sont eux-mêmes de nature complexe, même si les lois de base sont relativement simples.

Pour mémoire, les ondes électromagnétiques se répartissent en deux grandes catégories selon que leur énergie photonique est inférieure ou supérieure à 12,6 eV. En dessous de 12,6 électron-volt, l’énergie de l’on n’est pas suffisante pour arracher un électron à la couche externe d’un atome. Ces rayonnements sont donc qualifiés de « non ionisants » (2). Toutefois, s’ils ne générèrent pas d’ions positifs, ils « excitent » les atomes au niveau des couches électroniques internes (3).

(1) Exception faite pour le phénomène d’audition directe des micro-ondes (acouphènes d’origine électromagnétique) qui affecte certaines personnes.

(2) Un « ion » est un atome qui a perdu un électron ou capté un électron supplémentaire et qui, de ce fait, n’est plus en équilibre. Il est positif si sa charge positive (celle des protons de son noyau) prédomine. Il est négatif si sa charge négative (celle des électrons) prédomine. Les rayonnements dits « ionisants » sont ceux dont l’énergie est suffisante pour arracher des électrons aux atomes et les transformer en ions positifs. L’ionisation artificielle de l’air (qui est à la base de l’ionothérapie) consiste, au contraire, à produire des ions négatifs d’oxygène (oxions). Les ions ont une vie très courte car tout atome tend à retrouver son état d’équilibre en cédant ses électrons excédentaires (cas des oxions) ou en reconstituant sa couche externe en captant des électrons.

(3) Comme pour les ions, les atomes « excités » tendent à retrouver leur état stable. Les électrons qui ont changé de couche reprennent leur position nominale en cédant l’énergie acquise lors du « saut » (passage d’une couche à une autre). C’est cette énergie produite à l’intérieur des atomes qui explique, du moins en partie, les pathologies générées par les rayonnements non ionisants et que l’on qualifie de « non thermiques ».

Dans un rapport daté de juin 2001 (mis à jour en 2002) (4), Daniel DEPRIS a longuement exposé les principes qui régissent la métrologie des rayonnements de courte longue d’onde (hyperfréquences ou « micro ondes »). Voici, en substance, ce qu’énonce, ce document en ce qui concerne les appareils de mesure.

« …Dans la pratique, les appareils de mesure se basent sur les niveaux de champs fournis par une sonde qui capte, soit le champ électrique, soit le champ magnétique. On peut sur cette base, obtenir mathématiquement la densité de puissance du champ composé (en W/m² ou sous-multiples usuels de cette unité). C’est cette manière de procéder qui explique la succession de valeurs minimales et maximales que l’on projette sous forme d’une courbe moyenne.

Dans le cas d’une fréquence de 900 MHz, les minima et les maxima se succèderont tous les 16 cm environ (soit la moitié de la longueur d’onde). A 1800 MHz, ils ne seront plus séparés que de 8 cm. Il suffit donc parfois de déplacer le capteur (antenne, bobine , bolomètre,…) de quelques centimètres pour modifier très sensiblement le niveau des valeurs qu’un mesureur peut afficher. Il en résulte que le meilleur et le plus cher des matériels de mesure peut fournir des indications totalement fausses s’il est mal utilisé (involontairement ou volontairement). Mettre un analyseur de spectre Rohde & Schwartz dans les mains d’un individu incompétent (ou malhonnête) reviendrait à confier une Ferrari à un chauffeur du dimanche !

Une parfaite maîtrise de la métrologie des phénomènes physiques périodiques est donc indispensable si l’on veut obtenir des données fiables et utiles. Dans le domaine des antennes d’émission, on tiendra notamment compte des lois physiques qui régissent la formation des ondes qui sont émises par tel ou tel type d’antenne. Il faut en effet rappeler que lorsque l’on se situe dans le proche environnement d’une antenne, il devient difficile de mesurer les valeurs vraies des champs électromagnétiques avec les moyens classiques.

On nomme « champ proche » d’une antenne, la région de l’espace pour laquelle les deux composantes de l’onde ne sont pas en parfaite cohérence (*)… ».

(4) Rapport relatif aux relais hertziens destinés à la radiotéléphonie mobile et portable (et systèmes assimilés) – Caractéristiques techniques – Incidences sur l’environnement et la santé. Editions du CEPHES (sur CD-Rom) – 142 pages.

(*) On ne peut démontrer valablement les phénomènes qui interviennent en champ proche qu’en ayant recours à la physique quantique. Dans le très proche environnement d’une antenne, les photons obéissent à des lois qui ne correspondent pas aux classiques équations de Maxwell.

Il ne s’agit là cependant que d’un très court extrait d’un rapport qui comporte près de 150 pages et qui sera réactualisé prochainement. On y trouve de très nombreuses illustrations (dessins, photos, graphiques, diagrammes, tableaux,…) qui permettent d’aborder succinctement les différents aspects, théoriques et pratiques, de la métrologie des rayonnements électromagnétiques non ionisants.

Outre les diagrammes classiques, on peut visualiser la façon dont une antenne distribue l’énergie électromagnétique dans l’espace en recourant à une modélisation volumétri-que.

Le dessin, ci-dessus, permet de visualiser la répartition théorique de l’énergie électromagnétique pour un type d’antenne déterminé (en l’occurrence une antenne quadripôle). Dans ce cas, il n’y a pas de champ dans l’axe d’alignement des éléments (z) mais il n’y a pas non plus de champ dans le plan équatorial (x et y). Le champ est maximum le long d’un cône faisant un angle de 45° avec l’axe. Il ne s’agit cependant que d’un exemple parmi des milliers d’autres car chaque type, chaque modèle d’antenne possède son mode spécifique de répartition du rayonnement qui lui est appliqué.

La modélisation volumétrique est celle qui permet la meilleure compréhension du problème mais il faut considérer qu’elle est théorique et concerne surtout la propagation des ondes dans le proche environnement de l’antenne. Dans la pratique, il faut tenir compte de toute une série de paramètres complémentaires et de variables qui compliquent le problème, surtout dans l’environnement complexe des villes et des sites industriels.

La répartition de l’énergie appliquée à une antenne se calcule selon des lois précises et selon la distance par rapport à l’antenne. On détermine ainsi plusieurs « zones » différentes pour lesquelles les modes de calcul sont également différents.

Pour la zone dite « de Fresnel », celle qui est la plus proche de l’antenne, on doit avoir recours à des modèles mathématiques spéciaux pour déterminer la valeur de l’énergie rayonnée car l’onde n’y est pas cohérente (elle n’est pas « formée »). Il existe aujourd’hui des logiciels spéciaux qui fournissent ces données pour différents modèles d’antennes (*). Au-delà de la zone de Fresnel, on trouve une zone intermédiaire, dite « de Rayleigh », où l’onde commence à acquérir sa cohérence. Les zones de Fresnel et de Rayleigh constituent le « champ proche » de l’antenne.

Cette illustration, extraite d’un article publié en février 2001 par la revue technique « Microwaves & RF », nous explique, de façon schématique, pourquoi une antenne directive (ici un dipôle), produira, en un point donné de l’espace, une puissance apparemment supérieure à celle que produirait, au même point, une antenne isotrope rayonnant la même puissance Pïn (puissance injectée). C’est ce qui détermine la notion de « puissance apparente rayonnée » (p.a.r.) ou de « puissance isotrope rayonnée équivalente » (Pire). La différence de puissance apparente rayonnée générée par deux antennes différentes est fonction de leur « gain » par rapport à l’antenne de référence.

De façon pratique, on dira que si l’on expose une surface quelconque (comme la peau d’un animal ou d’un être humain) aux rayonnements générés par un émetteur dont la puissance Pin est connue, la « densité de puissance » (ou « éclairement énergétique ») qui affectera une unité de surface, donc de son gain. Ainsi, par exemple, si un émetteur de 10 W rayonne son énergie par l’intermédiaire d’une antenne supposée isotrope, on verra que pour une distance déterminée, chaque cm² de la peau d’un sujet exposé recevra, par exemple, 10 µW/cm². Mais si l’on remplace l’antenne isotrope par une antenne directive à grand gain, le sujet situé à la même distance sera affecté par une quantité d’énergie beaucoup plus grande alors même que la puissance de l’émetteur n’aura pas changé. Ainsi, si le gain est, par exemple, de 18 dBi (18 décibels par rapport à l’antenne isotrope), chaque cm² recevra 64 fois plus d’énergie soit 10 x 64 = 640 µW/cm² ou 0,64 mW/cm².

Il est indispensable de bien s’imprégner de ces notions élémentaires de physique radioélectrique si l’on veut comprendre ce qui se passe effectivement dans l’environnement d’une ou de plusieurs antennes émettrices. Ces notions sont relativement simples et à la portée de n’importe qui car elles n’exigent pas de connaissances mathématiques particulières.

Après la zone de Rayleigh, vient la zone « de Fraunhofer » qui constitue le début de la zone « de champ lointain » où le front d’une onde sphérique peut être assimilé à une onde plane pour laquelle E² x 377 - ou H² que divise 377 - équivaut à la densité de puissance « P » (ou D pour certains auteurs). E étant énoncé en V/m et H en A/m, la multiplication de l’un par l’autre fournit également la valeur de P en W/m².

Ce dessin nous donne une idée de ce que peuvent être les trois zones pour une antenne de type parabolique à faisceau très étroit. L’onde électromagnétique ne sera parfaitement formée, donc conforme aux lois de Maxwell, qu’au delà de la zone de Rayleigh.

(*) Cette zone porte le nom du grand physicien français Augustin-Jean Fresnel (1788-1827) car elle sont régies par des phénomènes analogues à ceux dont il fit la description et l’analyse mathématique en étudiant les ondes lumineuses. Ces phénomènes découlent, en effet, des lois de la diffraction des rayonnements électromagnétiques, surtout dans le domaine des courtes longueurs d’onde. Dans les zones dites « de Fresnel », les composantes fondamentales du rayonnement interfèrent et peuvent être en phase ou en opposition de phase, autrement dit s’additionner ou s’annuler. Dans le champ proche d’une antenne, il existe, en fait, un nombre n de zones de Fresnel que l’on ramène, par facilité, à une seule zone. On comprend qu’il est impossible d’appliquer à cette zone les lois classiques de l’électromagnétisme. On ne peut déterminer les valeurs de champ en un point précis qu’en se référant aux intégrales de Fresnel ou à certains modèles, tels que les « spirales de Cornu ».

Rayleigh et Fraunhofer ont aussi étudié le phénomène de la diffraction des ondes. C’est pourquoi leurs noms ont été donnés aux zones qui font suite à la zone de Fresnel. La diffraction de Fraunhofer est conforme aux lois générales de l’optique ondulatoire et s’accordent avec celles de l’électromagnétisme telles qu’elles ont été établies par Maxwell (1831-1879) et quelques autres. La diffraction de Fraunhofer explique certains phénomènes que l’on peut constater dans l’environnement « lointain » (physiquement parlant) des antennes et notamment des antennes directives dont le rayonnement vers l’arrière est faible ou nul. La méthode mathématique de Fraunhofer découle elle-même du modèle simplifié dit « de Kirchhoff-Huygens ». Pour plus de détails, voir notamment l’excellent cours d’électro-dynamique et de propagation des ondes radioélectriques de V. Nikolski.

Ces quelques précisions sont nécessaires pour expliquer les problèmes de métrologie que l’on peut rencontrer dans le proche environnement d’une antenne ou de plusieurs antennes. Car ce qui est déjà compliqué avec une seule antenne devient extrêmement complexe avec plusieurs sources émettrices. C ‘est en cela que la métrologie des rayonnements hertziens est sans nul doute la plus complexe de toutes les formes connues de métrologie. Dans ce domaine, la moindre erreur de méthodologie peut générer des erreurs considérables.

On peut dire que la métrologie électromagnétique repose sur les impératifs suivants :

une parfaite connaissance de la physique générale

une parfaite connaissance de la physique des rayonnements

une parfaite connaissance de la physique des antennes

une parfaite connaissance du matériel de mesure et de la méthodologie qu’il implique.

Il va de soi que, pour mesurer des ondes, il faut savoir ce qu’est une onde et comment elle se propage. Mais il faut aussi connaître la physique des antennes car il en existe des centaines de types différents et, pour chaque type, des dizaines de modèles. Or, chaque type, chaque modèle, aura ses caractéristiques propres selon les besoins techniques auquel il répond. Dans le cas des relais de radiotéléphonie, il faut aussi tenir compte des réglages de l’antenne qui varieront selon le site considéré (notamment le réglage dans le plan horizontal ou « tilt »).

Ci-dessus et ci-dessous, le diagramme complet d’une antenne sectorielle utilisée par le groupe « Orange » (qui exploite la branche radiotéléphonie de France Télécom) pour certains de ses relais GSM. Ce diagramme se décompose en une visualisation dans le plan vertical et une autre dans le plan horizontal.

Il s’agit d’une antenne de la marque Kathrein dont le lobe principal est ici incliné de 8° par rapport à l’horizontale (Source : CEPHES – Dossier Balma). Ces documents sont assez complets et permettent de déterminer la direction et l’importance des rayonnements déterminés par les lobes secondaires, tant vers le haut et vers le bas que vers l’avant et l’arrière. On remarquera qu’il existe ici un petit lobe situé sous l’antenne et juste à la verticale de celle-ci.

De tels documents sont difficiles à obtenir. Bien souvent, les opérateurs ne fournissent que des diagrammes très simplifiés et de petite dimension qui ne sont d’aucune utilité pratique pour l’expert. En outre, il faut savoir interpréter ces diagrammes et les extrapoler sur le terrain en réalisant des projection « in situ ».

Ces diagrammes très précis démontrent néan-moins que les opérateurs téléphoniques sont parfai-tement en mesure de produire les documents détaillés aux personnes et aux autorités qui en font la demande.

De tels diagrammes devraient obligatoirement être transmis aux mairies pour tous les sites d’émis-sion implantés sur le territoire d’une commune. Ils devraient pouvoir être librement consultés par les citoyens, qu’ils soient concernés directement ou indirectement par ces ins-talations.

Lorsque l’on dispose des diagrammes détaillés (mais néanmoins théoriques) et de la puissance apparente rayonnée (p.a.r ou p.i.r.e.) de l’installation considérée, on peut déterminer mathématiquement le niveau de pollution en un point déterminé de l’environnement. Si les calculs sont faits correctement, ils fournissent des données précises qui seront confirmées par les mesures et qui, parfois, sont plus précises que les mesures elles-mêmes. Mais rares sont les spécialistes capables de faire de tels calculs.

Visualisation du champ E généré par une antenne de relais GSM (900 MHz) à un mètre sous le plan médian du lobe principal. On constate que les mesures ne deviennent parfaitement cohérentes qu’à environ 15 mètres de l’antenne (source : CNET 1997). On voit que si une mesure du champ E est faite entre 1 m et 15 m de l’antenne, elle ne fournira que des informations non significatives. A environ 5,50m de l’antenne, on ne trouvera même pas 0,3 V/m cependant que la valeur de E sera de 2 V/m à 15 mètres. Comme d’autres documents de ce genre, ce graphique est purement informatif puisqu’il correspond à une puissance HF purement théorique de 1 W. Pour d’autres niveaux de puissance HF, il faut recalculer les valeurs en conséquence.

Le dessin reproduit ci-dessus est l’un de ceux qui démontrent la complexité du problème. On voit comment la composante électrique de l’onde (champ E) pourra varier selon l’installation d’une source émettrice (ici sur un château d’eau). Nous avons là, à titre d’exemple, deux relais (ou stations de base) de même puissance, montés sur un même support mais ayant des diagrammes de rayonnement et des réglages de tilt différents. Il en résulte des variations de champ selon les courbes 1 et 2, très différentes l’une de l’autre.

Un autre document extrait des archives du CEPHES montre comment on peut extrapoler un diagramme déterminé en fonction d’un site déterminée.

Ce dessin permet d’évaluer l’exposition de bâtiments situés à moins de 100 mètres d’un relais de radiotéléphonie implanté sur une tour ou sur un immeuble élevé (30 à 35 mètres par rapport au niveau du sol). Les valeurs indiquées (en µW/cm²) sont valables pour une puissance HF de 20 à 25 W et un gain d’antenne de l’ordre de 14 à 15 dB (ou 10 à 12 W et 18 dBi de gain).

On remarque que l’exposition la plus élevée serait mesurable dans le petit bâtiment à deux étages situé très près de la tour. Au second étage de ce bâtiment, la densité de puissance serait, en ordre moyen, comprise entre 0,25 et 0,4 µW/cm² dans l’axe de l’un des lobes secondaires. Mais il faut se souvenir du fait que, dans de telles situations, on peut mesurer des valeurs plus élevées lorsque des « hot spots » (points chauds) sont provoqués par des réflexions parasites. Le 3e bâtiment, bien que situé en partie dans l’axe du lobe principal, ne subirait que des densités de puissance inférieures à 0,2 µW/cm² s’il se trouvait situé à plus de 50 mètres des antennes mais une pollution plus importante s’il était plus proche de la tour. Le second bâtiment ne subit pas d’expositions conséquentes s’il mesure moins de 22 mètres de hauteur.

De tels exemples sont déterminés par la théorie en fonction d’un certain diagramme de rayonnement. Pour un diagramme différent et des paramètres différents (distances, puissance HF, gain d’antenne,…), les valeurs calculables seraient évidemment différentes. Ce schéma est donc, une fois encore, purement illustratif et indicatif. Dans la pratique, une schématisation de ce type devra toujours être faite cas par cas en fonction des données techniques qui auront été recueillies ou des mesures qui auront été effectuées sur le terrain.

Les exploitants d’émetteurs hertziens sont donc dans l’obligation de fournir tous les éléments techniques qui permettent de déterminer la nocivité potentielle d’une installation déterminée, essentiellement les caractéristiques détaillées des antennes (diagramme et gain) et des émetteurs (fréquences, puissance HF appliquée aux antennes et puissance maximale). Le fait, pour un exploitant, de refuser de produire ces informations peut être considéré comme un vice de forme et est de nature à rendre caducs les contrats autorisant l’exploitation de l’installation incriminée. Il en va de même lorsqu’il est prouvé que des informations mensongères ont été produites par lesdits exploitants en vue de tromper les décideurs publics et les populations concernées. Un arrêt du Tribunal d’Instance de Montpellier (décembre 2000) a d’ailleurs conclu en ce sens en faisant intervenir la notion de « dol » dans sa décision. Pour mémoire le « dol » (du latin dolus : ruse) désigne, en droit, le fait d’user de tromperie pour obtenir la conclusion d’un contrat. Or, il est avéré que les opérateurs téléphoniques ont, de façon quasiment systématique, usé de manœuvres de ce genre pour obtenir les accords permettant l’implantation de leurs stations de base.

Toute modélisation, même informatique, ne peut avoir qu’une valeur indicative et plus ou moins approximative. Mais dans la plupart des cas, on pourra se satisfaire de ces approximations. Il faut aussi considérer que les paramètres peuvent varier assez sensiblement en fonction du type d’antenne considéré. Avec certaines antennes à très grand gain, on pourrait dépasser les 30 µW/cm² à 1 mètre et toujours pour 1 watt.

Avec un relais GSM 900 MHz, nous avons vu que la zone d’incohérence est d’environ 15 mètres (avec les antennes classiquement utilisées). Pour une installation DCS 1800 MHz, la zone d’incohérence serait moins étendue (7 à 8 mètres) tandis que pour les installation UMTS (mais aussi Wi-Fi, bluetooth,…), elle serait encore un peu plus réduite (env. 6 à 7 mètres).

S’il est difficile de déterminer mathématiquement les niveaux de pollution RF/MO, il n’est pas plus facile de les mesurer. Car le matériel de mesure digne de ce nom est d’une grande sensibilité. Il est notamment très sensible aux variations de tempéra-ture car les capteurs de champ et les circuits sont conçus pour une température déterminée (généralement 20°C) et ne fournissent des informations correctes que pour cette température dite « d’étalonnage ». Dès que l’on s’en écarte, il faut considérer et appliquer des facteurs de correction. Le métrologiste qualifié devra donc impérativement tenir compte de la température ambiante (en intérieur comme en extérieur), laquelle devra être consignée dans son rapport pour chaque point de mesure effectué. C’est pourtant une précaution que la plupart des pseudos « experts » ignorent superbement !

Comme indiqué, la parfaite connaissance du matériel de mesure est essentielle. N’importe qui peut faire l’acquisition de ce type de matériel (il suffit d’en avoir les moyens) mais cela ne signifie pas que n’importe qui est à même de s’en servir et d’en tirer des informations utiles. Il est très facile de « faire semblant de prendre des mesures ». Il est très difficile de prendre des mesures dignes de ce nom.

Le matériel a énormément évolué au cours des 50 dernières années. La photo, ci-dessous, montre un récepteur de radiométrie datant des années 50. Il fut utilisé par Daniel Depris jusqu’au début des années 80.

Ce mesureur Rhode & Schwartz était utilisé par les techniciens militaires pour déterminer le réglage des stations émettrices dans la bande HF. Il pouvait aussi servir pour des relevés radiogoniométriques. Son utilisation en extérieur était délicate et compliquée. Il était associé à un système d’antennes calibrées que l’on installait sur un support orientable.

Les premiers radiomètres portatifs firent leur apparition après l’invention du transistor, à la fin des années 60. Ils étaient plus faciles à mettre en œuvre, plus légers mais toujours aussi délicats. En 1984, Daniel Depris concevra son prototype PEM 15 qui ne sera cependant jamais commercialisé. Il développera aussi une série de détecteurs de pollution RF/MO, appareils beaucoup plus simples et forcément moins précis.

Ci-dessus, le protoype du PEM 15-1, un mesureur de champ à très large bande conçu par D. Depris. A gauche, l’un des premiers modèles de détecteur de la série PEM 6. Les deux appareils se ressemblent extérieurement mais ils n’appartiennent pas du tout à la même catégorie de matériel. L’un est un véritable appareil de mesure, l’autre est un simple détecteur. Il n’est pas facile, pour les personnes non qualifiées de faire la différence et l’on vend souvent, sous l’appellation « appareil de mesure » des « bidules » qui ne fournissent aucune indication valable.

Les véritables mesureurs demeurent des appareils complexes, donc coûteux à développer et à fabriquer. Il est pratiquement impossible de proposer un appareil de mesure des rayonnements RF/MO à moins de 2.000 euros (prix neuf). Par contre, le coût de fabrication des détecteurs est beaucoup moins important et on peut les proposer à moins de 100 euros.

Il faut aussi savoir qu’il existe deux grandes catégories de mesureurs : les mesureurs de champ et les analyseurs de spectre. Les premiers travaillent généralement « en bande large » et ils mesurent l’une des composantes de l’onde (le champ électrique E ou le champ magnétique H). Ces radiomètres fournissent donc une information en V/m ou en A/m mais ils sont souvent équipés d’un système de conversion qui fournit une indication en « densité de puissance » (µW ou mW par cm²). Le plus souvent, c’est le champ E qui est mesuré. Certains mesureurs fournissent les valeurs en dB/µV, ce qui ne simplifie pas le problème, même s’il existe des tableaux permettant de convertir les valeurs données avec des unités différentes. Ces tableaux figurent dans le rapport de Daniel Depris. On peut aussi rencontrer des mesureurs dont les indications sont en µV. Il faut alors convertir les µV en dB/µV puis les dB/µV en V/m ou en µW/cm².

Ci-contre, le mesureur de champ PMM 8053 qui permet la mesure des composantes E/H sur une très large bande de fréquences (5 Hz à 40 GHz).

Il reçoit de nombreuses sondes et reconnaît automatiquement le type de sonde installée lors de la mise sous tension. Sa dynamique de mesure est de 100 dB cependant que la mémoire interne peut enregistrer jusqu’à 8.000 points de mesure E ou H.

Outre les mesures de champ E/H, cet appareil permet une analyse fréquentielle des basses et très basses fréquences (5 Hz à 100 kHz). Ce genre de matériel est très complet mais aussi très cher.

Ci-contre, l’analyseur de spectre Protek 3201. C’est un appareil très compact qui couvre les fréquences comprises entre 9 MHz et 2.060 Mhz (100 kHz à 2,06 GHz en réception). Ce matériel coréen couvre donc les fréquences actuellement utilisées pour la radio-téléphonie cellulaire mais se trouve dépassé par les technologies hertziennes qui recourent à des fréquences supérieures à 2 GHz.

Il existe actuellement une dizaine de mesureurs à bande large qui sont véritablement de qualité professionnelle. En Europe occidentale, les plus utilisés sont sans nul doute les mesureurs Chauvin-Arnoux (CA43) et Wandel & Goltermann (séries 20/30 ou 200/300).

Les analyseurs de spectre fournissent des informations plus complètes. Outre le niveau de pollution, ils permettent de déterminer la (ou les) fréquence(s) des rayonnements qui contribuent à cette pollution. Ils permettent donc d’identifier les sources émettrices, ce que ne font pas les mesureurs à bande large. En effet, si un mesureur à bande large fournit une valeur de pollution en un point déterminé, il ne fournit aucune donnée sur la ou les fréquence(s). On ne peut donc pas savoir si la pollution est engendrée par un relais de téléphonie ou par un autre émetteur situé dans les environs (radio, TV,…).

Les analyseurs les plus précis sont ceux que l’on destine aux laboratoires mais ils sont d’une utilisation délicate en extérieur. Ce sont pourtant ces appareils là que l’on utilise généralement lorsqu’une entreprise de téléphonie (ou autre activité de télécom, de radiodiffusion, de télévision,…) accepte de procéder à des mesures de pollution.

Cela tient sans doute à des motifs qui ne sont pas d’ordre strictement technique. Les gros analyseurs de laboratoire sont de nature à impressionner les personnes non averties. Ils « font sérieux ». Ils permettent surtout de truquer les mesures très facilement et sans que personne (ou presque) ne puisse s’en apercevoir. Daniel Depris a mentionné le fait dans plusieurs de mes rapports, notamment dans celui qu’il rédigea après avoir été amené à constater la méthodologie de travail des techniciens de l’Apave, à Lauzerte (Tarn-et-Garonne). Ce fut aussi le cas dans d’autres circonstances où le président du CEPHES refusa de cautionner des mesures effectuées avec un matériel non vérifiable.

En effet, lorsque l’on considère le matériel de laboratoire, il faut parler d’une « ligne de mesure » qui va du capteur (en général une antenne) jusqu’au mesureur (par exemple un analyseur de spectre) en passant par des câbles et des connecteurs. Le moindre défaut, la moindre anomalie dans cette « ligne » aura pour conséquence de produire des mesures erronées, parfois dans des proportions difficilement imagina-bles. Un technicien qualifié peut donc truquer des séances de mesure avec une facilité dérisoire. Il lui suffira, par exemple, d’utiliser un câble non adapté aux fréquences considérées ou endommagé (sans que cela soit visible). Le simple fait d’écraser le câble avec le pied peut le rendre inopérant. Il en va de même sir l’un des connecteurs est mal soudé. Les métrologistes connaissent ces problèmes. C’est pour cette raison que les antennes et les câbles doivent être vérifiés en laboratoire avant d’être utilisés en extérieur. Mais si ces accessoires sont défectueux, personne ne pourra le constater sur place. C’est là que réside l’astuce.

A Lauzerte, il avait aussi été constaté que l’émetteur de la Sté Bouygues Télécom ne produisait pas la puissance figurant dans la notice technique. C’est sur l’insistance de D. Depris (mandaté par une association locale) que des mesures de puissance HF furent réalisées avant les mesures de champ. Il fut alors constaté que l’émetteur ne produisait que 22 % de la puissance maximale qu’il pouvait délivrer. Dans le Lot-et-Garonne, la Sté SFR avait fait démonter un élément d’une antenne trisectorielle juste avant que les mesures soient effectuées. Les possibilités de trucage sont donc variées et elles échapperont à toute personne n’ayant pas une grande expérience dans le domaine des transmissions et de la métrologie des rayonnements.

Ci-contre, les différents contrô-les qui permettent de qualifier un système de mesure RF/MO (extrait d’un article publié dans « Contact » - revue éditée par Chauvin-Arnoux – n° 53 – Eté 2000).

On notera qu’il est impératif de mesurer la puissance délivrée par le générateur (émetteur) à l’aide d’un wattmètre ou d’un wattmètre-réflectomètre ainsi que les paramètres inhérents aux éléments de liaison, essentiellement les câbles et les connecteurs. Les principales pertes d’insertion sont, en effet, imputables aux câbles et à la connectique.

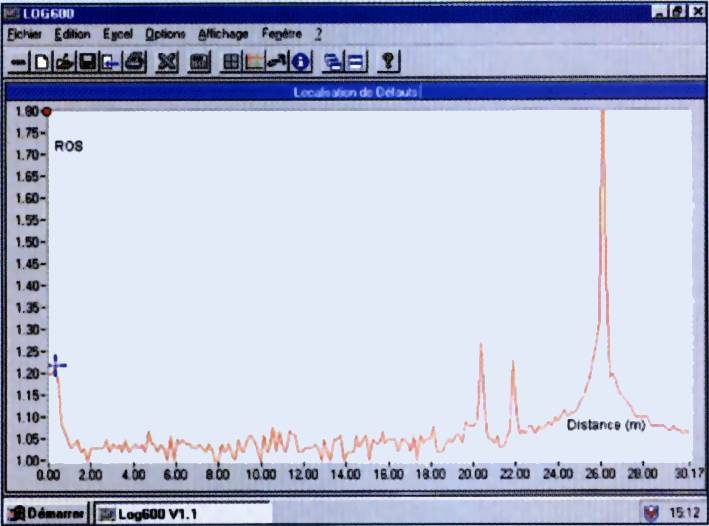

Le second document (source : Oritel) montre comment l’on peut découvrir des défauts dans les câbles à l’aide d’un contrôleur scalaire. Le logiciel associé au contrôleur indique ici un grave défaut à 26 mètres du point de départ (ROS atteignant 1,8) et deux défauts moyens à 20 et 22 mètres. De tels défauts peuvent résulter d’un simple écrasement acci-dentel du câble, ce qui entraîne une modification localisée de son impédance.

Aux fréquences UHF (300 MHz à 3 GHz), les pertes en ligne sont très importantes dès que le câble de liaison dépasse quel-ques dizaines de centimètres.

Il existe donc différentes catégories de câbles selon les fréquences considérées. Ils se distinguent par leur numéro de référence. On peut truquer aisément une séance de mesure en utilisant délibérément un câble non adapté, par exemple un câble HF au lieu d’un câble UHF. On peut ainsi, sans attirer l’attention, atténuer le signal de plusieurs dB, voir de plusieurs dizaines de dB. Si, par exemple, l’atténuation est de 13 dB, le signal parvenant au mesureur sera 20 fois inférieur à ce qu’il aurait dû être.

A Lauzerte, j’ai indiqué que j’avais été dans l’incapacité de vérifier la parfaite conformité de l’ensemble de la ligne de mesure. Je ne pouvais donc, en aucune façon, cautionner les mesures réalisées par l’Apave comme le maire l’aurait souhaité. Aucun expert digne de ce nom n’accepterait de cautionner des mesures réalisées avec un matériel dont il n’a pas pu vérifier tous les paramètres.

Les trucages impliquant les connecteurs et les câbles sont sans doute les plus fréquents mais on peut aussi tripoter les mesures en utilisant une antenne non adéquate. Ce fut le cas à Toulouse lorsqu’en présence de D. Depris, un technicien agréé par TDF fut sur le point de faire des mesures avec un analyseur de spectre auquel avait été couplé une antenne qui n’était pas du tout adaptée aux fréquences qui étaient générées par les émetteurs incriminés. Interpellé par le président du CEPHES, le technicien se confondit en excuses. Il s’était « trompé ». Ben voyons !

Actuellement, la plupart des organismes et entreprises « agréés » sont sous la dépendance directe ou indirecte des grandes compagnies industrielles et commerciales ainsi que des ministères de tutelle (eux mêmes inféodés aux intérêts industriels et financiers). Leur personnel a manifestement été formé pour produire des mesures falsifiées allant dans le sens des intérêts des grands lobbies. Mais il est très difficile d’en faire la démonstration sans avoir une très longue expérience dans le domaine de la physique des rayonnements et de la métrologie.

Ci-contre, exemple de données que peut fournir un analyseur de spectre dans l’environnement d’un site d’émission. Il s’agit ici des raies spectrales des émetteurs de radiodiffusion FM installés en haut de la tour Eiffel (mesures d’avril 1989 sur la plate-forme du 3e étage).

Sur ce document, les pointes les plus élevées correspondent à un champ d’environ 50 V/m mais d’autres points de mesure ont permis de mettre en évidence des champs compris entre 100 et 300 V/m. Les mesures avaient été faites à l’aide d’une boucle Stoddart.

Dans certains cas, il peut être utile de faire deux séries de mesures, l’une en large bande, l’autre en analyse du spectre. Si l’on utilise deux appareils couvrant les mêmes bandes, la somme des valeurs relevées en balayage de spectre doit être à peu près identique à celle que donne le mesureur de champ à large bande.

Aujourd’hui, il est devenu courant de coupler l’appareil de mesure à un ordinateur portable ou à un système de mémorisation. Ces appareils enregistrent les données et permettent un traitement accéléré des informations. Ils ne sont cependant que des éléments périphériques qui doivent faciliter l’établissement des rapports sans interférer, en aucune manière, au niveau des mesures proprement dites. Il faut notamment veiller à ce que les logiciels ne soient pas susceptibles de se transformer en sources d’erreurs.

Compte tenu de la grande variété de matériel qui peut être utilisé en fonction des besoins et des circonstances, il est devenu plus commode de louer ce matériel que d’en faire l’acquisition. Le matériel qui est proposé par les sociétés spécialisées dans la location de matériel de mesure est un matériel récent qui bénéficie d’une maintenance régulière et qui est réétalonné après chaque sortie. Il faut cependant tenir compte du fait que ce matériel est généralement loué pour des périodes qui ne peuvent être inférieures à une semaine, d’où l’intérêt qu’il peut y avoir à grouper les travaux de métrologie chaque fois que cela s’avère possible.

Il faut aussi savoir que le matériel de mesure, aussi bon soit-il, doit être l’objet de soins attentifs et d’un réétalonnage régulier. Or, ce réétalonnage doit être fait en laboratoire (qui délivre un certificat ad hoc). Certains prétendus « experts », qui ont fait l’acquisition de mesureurs, ignorent cette nécessité de faire vérifier régulièrement la matériel par un laboratoire de métrologie qualifié (en général le service technique du fabricant). Enfin, la méthodologie de travail impose certaines précautions afin que le métrologiste n’interfère pas lui-même dans le système de mesure.

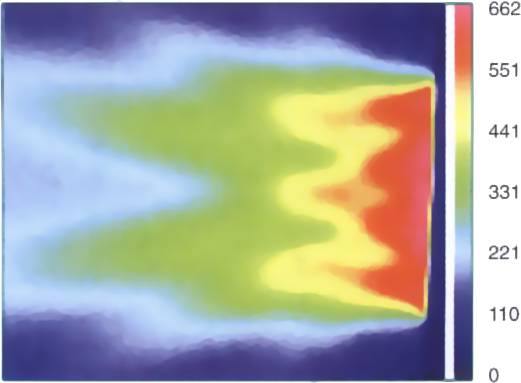

Exemple de visualisation du champ électrique en champ proche par la méthode informa-tique EMIR. Il s’agit ici du champ électrique généré par une antenne-cornet et l’on remarque que, dans ce cas de figure (qui correspond à des paramètres bien précis), on atteignait les 662 V/m à proximité immédiate de l’antenne (zone colorée en rouge). La densité de puissance équivalente à 662 V/m est 116,245 mW/cm². Un tel niveau d’irradiation peut être mortel à courte échéance.

La méthodologie EMIR est utilisée par l’armée française mais elle peut aussi être mise en œuvre pour visualiser les valeurs de champs E et H dans le proche environnement de n’importe quelle installation d’émission, y compris les relais de radiotéléphonie et les téléphones portables. La modélisation EMIR produit des documents d’une grande précision et faciles à interpréter, mais il convient que les paramètres qui sont fournis à l’ordinateur soient exacts et complets. Exploité par un informaticien malhonnête ou incompétent, le logiciel EMIR (ou tout autre du même type) pourra produire des documents totalement faux, tout comme les appareils de mesure qui sont utilisés de façon incorrecte.

Ces quelques pages ont pour objet de résumer une problématique extrêmement complexe mais qui concerne de plus en plus de monde dans nos pays de plus en plus pollués par des sources électromagnétiques de plus en plus nombreuses.

Elles tendent à démontrer que l’on ne doit pas se fier « à priori » aux mesures qui sont faites par des organismes officiels ou par des entreprises (ou associations) agréés par les milieux industriels et commerciaux (ou par les ministères de tutelle, comme le ministère français de l’Industrie). Mais elles tendent aussi à démontrer qu’il est difficile de faire la démonstration des supercheries (voir nos précédents communiqués).

Enfin, elle incitent à la prudence vis-à-vis de personnages qui se qualifient d’ « experts indépendants » mais qui n’ont pas une réelle compétence dans le domaine de la métrologie. Ils peuvent faire un mauvais travail mais ils peuvent, eux aussi, produire des rapports truqués (dans le sens inverse). C’est ainsi qu’un pseudo « expert « ondes nocives » (géobiologue) fut un jour pris en flagrant délit tandis qu’il avait dissimulé, dans l’une de ses poches, un petit émetteur qui lui permettait d’influencer son « appareil de mesure » (par ailleurs anormalement sensible et pas du tout conforme aux règles de la métrologie).

Des « bidules » ressemblant à des appareils de mesures ont d’ailleurs été fabriqués spécialement pour les adeptes de la radiesthésie-géobiologie. Ils servent à psychoser les personnes naïves ou mal informées (voir nos précédents communiqués). Un certain nombre de ces bidules ont été testés par le CEPHES mais il en existe à présent un trop grand nombre pour qua nous puissions donner un avis sur ces gadgets qui sont à la métrologie ce que le Canada Dry est à l’alcool. Tout ce que nous pouvons dire, c’est qu’il ne faut jamais se fier à l’apparence exté-rieure d’un appareil. Une belle boîte, de beaux boutons et un beau cadran ne font pas nécessairement un bon appareil.

Vue partielle du laboratoire de métrologie de la Sté Anonyme de Mécanique et d’Armement (Mécar) de Petit-Roeulx-lez-Nivelles, au début des années 60. C’est là que le président du CEPHES fit ses premiers pas dans le domaine des mesures de haute précision. Sur cette photo, on voit deux bancs de mesure de fabrication suisse (précision de l’ordre du micron) ainsi que le bac de mise à température des pièces à mesurer. Dans ce laboratoire, la température et l’hygrométrie étaient soigneusement contrôlés et stabilisés. L’accès du local se faisait par un sas.

Notons enfin qu’un prototype développé par D. Depris dans le courant des années 80 (le PEM 6) a été purement et simplement copié par une entreprise bruxelloise peu scrupuleuse. Le président du CEPHES avait été mis en relation avec cette petite entreprise qui prétendait pouvoir fabriquer des mesureurs en petite série. Cependant, il s’était avéré qu’elle n’avait pas les compétences nécessaires pour mener à bien une telle production.

Il n’empêche que le prototype fut copié sans aucune autorisation et sans que son concepteur en ait été informé. Ce n’est que par hasard que nous avons appris que le PEM 6 avait été commercialisé sous l’appellation DHF 1. Toutefois, le prototype confié à l’entreprise bruxelloise était incomplet. Il en fut de même pour sa copie qui, de ce fait, ne permet pas d’effectuer des mesures dignes de ce nom.

Le plagiat est dûment attesté du fait que l’entreprise incriminée n’a même pas eu le courage de concevoir un mode d’emploi. Elle s’est contentée de « corriger » le mode d’emploi rédigé par D. Depris pour le PEM 6. Il suffit de comparer les deux docu-ments pour s’en rendre compte immédiatement.

A gauche, le mode d’emploi du PEM 6 tel qu’il fut rédigé par Daniel Depris. A droite, celui du DHF 1 tel qu’on le trouve en accompagnement de la contrefaçon fabriquée à Bruxelles. On remarque que les corrections ont été faites à la main sur le document original.

Le plagiat est sans

contestation possible...

Tel qu’il a été commercialisé, le DHF1 n’est pas un appareil de mesure digne de ce nom. Sa mise en vente relève de l’arnaque.

Cet exemple illustre le manque flagrant d’honnêteté qui affecte des individus qui se présentent comme « fabricants d’appareils de mesure » mais qui ne sont, in fine, que des margoulins.